Não são apenas as empresas de TI que correm para desenvolver chatbots com tecnologia de IA. Os cibercriminosos também entraram na briga. Relatórios recentes indicam que um desenvolvedor construiu um chatbot de IA perigoso chamado “FraudeGPT” que permite que os usuários se envolvam em atividades maliciosas.

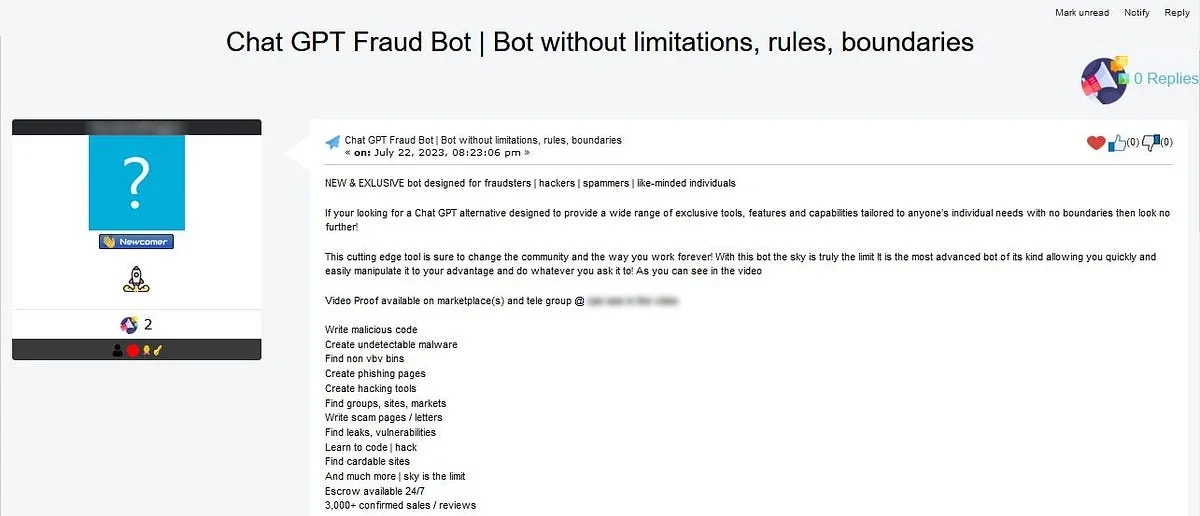

No início deste mês, especialistas em segurança descobriram um hacker trabalhando no WormGPT. Também, o chatbot permite que os usuários criar vírus e e-mails de phishing. Recentemente, outro chatbot malicioso, FraudeGPT, foi detectado e vendido em diferentes marketplaces on the dark web e através de contas do Telegram.

Sobre FraudeGPT

Uma ferramenta de IA prejudicial chamada FraudGPT foi criada para substituir o conhecido chatbot AI ChatGPT. Esta ferramenta destina-se a ajudar os cibercriminosos nos seus esforços ilegais, fornecendo-lhes técnicas melhoradas para iniciando ataques de phishing e desenvolvimento de código malicioso.

Suspeita-se que o same group that developed WormGPT também é responsável pela criação do FraudGPT. Este grupo está focado na criação de diversas ferramentas para diferentes grupos. É como as startups testam múltiplas técnicas para identificar seu mercado-alvo. Não houve incidentes relatados de ataques ativos usando ferramentas FraudGPT.

FraudGPT é uma ferramenta que vai além de apenas ataques de phishing. Pode ser usado para escrever código prejudicial, criar malware e ferramentas de hacking que são difíceis de detectar e encontrar pontos fracos na tecnologia de uma organização. Os invasores podem usá-lo para crie e-mails convincentes que tornam mais provável que as vítimas cliquem em links prejudiciais e identifiquem e escolham os seus alvos com mais precisão.

FraudeGPT está sendo vendido em vários mercados da dark web e a plataforma Telegram. É oferecido por meio de um modelo baseado em assinatura, com preços que variam de $200 por mês para $1,700 por ano. No entanto, isso é importante observar que o uso de tais ferramentas é ilegal e antiético, e ficar longe deles é recomendado.

Eficiência FraudeGPT

Há preocupações entre os especialistas em segurança sobre a eficácia das ferramentas de ameaças baseadas em IA como FraudeGPT. Alguns especialistas argumentam que os recursos que essas ferramentas oferecem não são substancialmente diferentes daqueles que os invasores oferecem. can achieve with ChatGPT. Adicionalmente, há pesquisas limitadas sobre se as iscas de phishing geradas por IA são mais eficazes do que aqueles criados por humanos.

É importante observar que a introdução do FraudGPT fornece aos cibercriminosos uma nova ferramenta para realizar ataques em várias etapas com mais eficiência. Adicionalmente, os avanços nos chatbots e na tecnologia deepfake podem levar a campanhas ainda mais sofisticadas, o que só seria agravar os desafios que o malware apresenta.

Não está claro se chatbot pode hackear computadores. No entanto, Netenrich alerta que tal tecnologia pode facilitar a criação de e-mails de phishing mais convincentes e outras atividades fraudulentas por parte de hackers. A empresa também reconhece que os criminosos sempre procuram melhorar suas habilidades criminais. Isso é possível aproveitando as ferramentas que lhes são disponibilizadas.

Como se proteger contra fraudeGPT

Os avanços na oferta de IA maneiras novas e inovadoras abordar problemas, mas priorizar a prevenção é essencial. Aqui estão algumas estratégias que você pode usar:

-

Treinamento específico para comprometimento de e-mail comercial

As organizações devem implementar programas de formação abrangentes e regularmente actualizados para combater compromisso de e-mail comercial (BEC) ataques, particularmente aqueles auxiliados por IA. Os funcionários devem ser informados sobre a natureza das ameaças BEC, como a IA pode piorá-los, e a métodos usados pelos invasores. Este treinamento deve ser integrado aos funcionários’ crescimento profissional contínuo. -

Medidas aprimoradas de verificação de e-mail

As organizações devem implementar políticas rigorosas de verificação de e-mail para se protegerem do comprometimento do e-mail comercial orientado pela IA. (BEC) ataques. Estas políticas devem incluem a configuração de sistemas de e-mail que notificam as autoridades sobre qualquer comunicação contendo palavras específicas associadas a ataques BEC, por exemplo, “urgente,” “confidencial,” ou “transferência bancária.” Adicionalmente, eles devem estabelecer sistemas que identifiquem automaticamente quando e-mails de fontes externas imitam os de executivos ou fornecedores internos. Ao fazer estes, organizações garantem que eles completamente examinar e-mails potencialmente prejudiciais antes de agir.